Mikä on ChatGPT ja mihin sitä käytetään?

Tämän päivän nopeatempoisessa digitaalisessa maailmassa yritykset etsivät jatkuvasti tapoja parantaa toimintaansa, vähentää kustannuksia ja lisätä tuloja. Yksi mahdollinen, ja paljon huomiota herättänyt, tapa saavuttaa tämä on käyttää tekoälyteknologioita, kuten ChatGPT:tä.

GPT on lyhenne sanoista Generative Pre-trained Transformer, eli autoregressiivinen kielimalli, joka käyttää syväoppimista ihmisen kaltaisen tekstin tuottamiseen. Sen julkaisi yhdysvaltalainen OpenAI-yritys vuonna 2020. Tämä malli ja sen helppokäyttöinen käyttöliittymä tuli laajemmin tunnetuksi alkusyksystä 2022 GPT-3:n julkaisun myötä. Tekoälyratkaisut kehittyvät juuri nyt hyvin nopeasti. ChatGPT-3 julkaistiin yleisölle alkusyksyllä 2022, jota seurasi kehittyneempi versio 3.5 ja keväällä 2023 julkaistiin vielä paljon kehittyneempi versio ChatGPT-4. GPT-4:n väitetään olevan 10 kertaa edistyneempi kuin edeltäjänsä GPT-3.5, ja sen avulla sille opetettu kielimalli ymmärtää huomattavasti paremmin kontekstia ja vivahteita, mikä johtaa selvästi tarkempiin ja johdonmukaisempiin vastauksiin.

ChatGPT ei ole taikuutta. Sen perustana oleva tekniikka perustuu Large Language Model (LLM) -malliin, joka on ollut käytössä paljon pidempään kuin vuodesta 2020 lähtien. LLM:ssä algoritmi on koulutettu suurella määrällä tekstipohjaista dataa, joka tyypillisesti on kerätty avoimesta internetistä ja se kattaa verkkosivut ja – LLM:stä riippuen – myös muita lähteitä, kuten tieteellisiä tutkimuksia, julkaisuja, väitöskirjoja, sanomalehtien sisältöjä tai sosiaalisen median viestejä.

Epäselvyyksien välttämiseksi mainittakoon, että markkinoilla on myös muita paljon ChatGPT:n kaltaisia tekoälyohjelmistoja, jotka perustuvat samaan GPT-kielimalliin. Niiden hyödyllisyys tai paremmuus riippuu paljon siitä, mihin ko. työkalua on tarkoitus käyttää.

ChatGPT:n tietoturvariskit

Vaikka ChatGPT:stä tullaan varmasti näkemään uusia ja parannettuja versioita, ominaisuuksia ja hyödyllisiä käyttötapoja, on aina tärkeää, kuten minkä tahansa tehokkaan ja uuden teknologian kohdalla, arvioida huolellisesti käyttöön liittyvät riskit. Esimerkiksi kaikkialla, missä on lähdekoodia, on myös salaisuuksia, ja ChatGPT:tä käytetään usein eräänlaisena koodiavustajana tai toisena kirjoittajana. Vaikka ChatGPT:ssä on jo esiintynyt tietomurtoja, kuten kyselyhistorian paljastuminen vahingossa ulkopuolisille käyttäjille, huolestuttavampaa on arkaluonteisten tietojen tallentaminen tavoilla, jotka ovat täysin sopimattomia ja turvattomia niiden arkaluonteisuuteen nähden.

Salaisuuksien kaltaisten arkaluonteisten tietojen tallentamisessa ja jakamisessa olisi aina noudatettava korkeaa turvallisuustasoa, johon kuuluu tallennettavan datan salaus, salausavaimien kontrollointi, tiukka käyttöoikeuksien valvonta ja yksityiskohtaiset lokitiedot, joista käy ilmi, missä, milloin ja kuka tietoja on käyttänyt. ChatGPT:tä ei kuitenkaan ole kunnolla suunniteltu arkaluonteisten tietojen käsittelyyn, sillä siitä puuttuu salausavaimien kontrollointimahdollisuus, tiukka pääsynvalvonta ja pääsylokit. OpenAI käyttää Microsoft Azure -pilvipalvelua kaikkien työkuormien suorittamiseen, kuten esimerkiksi datan prosessointiin, tietokantoihin, ja datan säilyttämiseen. Tällä hetkellä kaikki tämä data sijaitsee Microsoftin Azure-konesaleissa Yhdysvalloissa, ja EU-optiota ei ainakaan vielä ole palvelusta saatavilla, joten ainakin GDPR-mielessä tämän pitäisi herättää joitain ajatuksia. Lisäksi kolmannen osapuolen kielimallien käyttö voi myös herättää tietosuojaan, immateriaalioikeuksiin ja muihin säännöksiin liittyviä ongelmia. On tärkeää kuulla lakiasiantuntijoita ja ymmärtää täysin palveluntarjoajan asettamat käyttöehdot ja mahdolliset käyttörajoitukset.

Ilman asianmukaista kyberturvakoulutusta, ohjeistusta ja valvontaa ChatGPT:n käyttäjät voivat tahattomasti vaarantaa hyvinkin arkaluonteiset tiedot. Otetaanpa yksi hyvin yleinen esimerkki. Kuvitellaan, että yrityksen johtohenkilö pyytää ChatGPT:tä luomaan PowerPoint-kalvot sisäistä esitystä varten ja kopioi sovellukseen yrityksen strategia-asiakirjan viitteeksi. Tulevat ChatGPT-kyselyt keneltä tahansa yrityksen strategisista prioriteeteista, mahdollisesti jopa kilpailevien yritysten käyttäjiltä, voisivat siten saada yksityiskohtia suoraan kyseisen johtajan jakamasta yksityisestä yritysstrategia-asiakirjasta.

Edelliset kappaleet ja niissä mainitut ChatGPT:n tietoturvapuutteet saattavat saada yritysjohdon ajattelemaan palvelun täyskieltoa. Tällaisia esimerkkejä on mediassa jo esille noussutkin. Mielestäni tämä ei ole oikea ratkaisu. Tärkein syy tähän on se, että tekoäly on tullut jäädäkseen. Yritysten ei pitäisi vastustaa tekoälyvallankumousta vaan ottaa se kontrollimenetelmien kautta hyötykäyttöön.

Vaikka mahdolliset tietovuodot ovat aina oikeutettu huolenaihe, tekoäly voi olla myös arvokas työkalu, jos yritykset ymmärtävät sen tarkoituksen ja rajoitukset. Kouluttamalla työntekijöitä ja suojaamalla yritystietoja moderneilla teknologioilla, yritykset voivat hyödyntää tekoälyn etuja turvallisuudesta tinkimättä.

Tekoälypalveluiden hallittu käyttö

Kuten mainittu, ChatGPT ja muut tekoälychatbotit ovat saaneet viime aikoina paljon huomiota. Ne edustavat jännittävää uutta digitaalista ulottuvuutta, mutta tietoturvan kannalta ne ovat myös uusi paikka, jonne yritystiedot voivat ns. ”vahingossa” päätyä. Mitä voimme siis tehdä sen valvomiseksi?

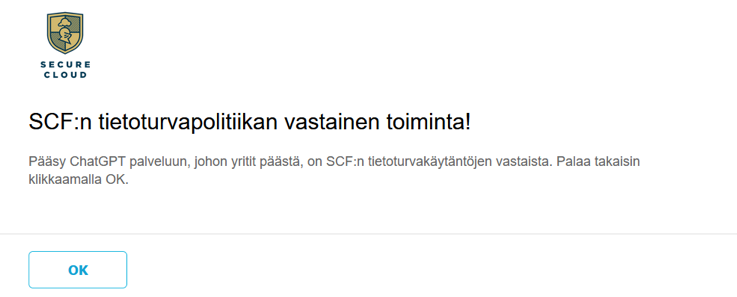

ChatGPT:n täydellinen esto

Estää pääsyn palvelun takana olevan yrityksen, OpenAI, openai.com-verkkotunnukseen. Todennäköisesti tämä voi olla tyypillisin ja helpoin lähestymistapa, jota yritykset ensimmäisenä miettivät, ja valitettavasti tämä on myös ainoa tapa useille tietoturvatekniikoille, kuten NGFW-palomuurit, perinteiset proxyt ja päätelaitteiden suojauksessa käytettävät EDR-ratkaisut sisällönsuodatusominaisuuksineen. Itse emme tätä menetelmää suosita, mutta joillekin tämä voi sopia.

Hieman vähemmän perinteinen lähestymistapa

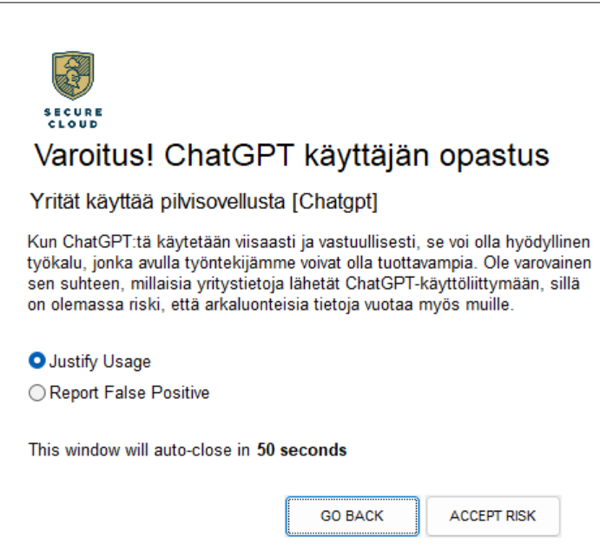

Valmentaa käyttäjiä ChatGPT:n käytössä. Tämä vaatii jo sellaista teknologiaa, joka ymmärtää datan sisällön. Tässä voidaan käyttää edellistä lähestymistapaa (OpenAI:n URL-osoitteen estäminen) ja hienosäätää sitä hieman, jotta yrityksen työntekijät pääsevät käyttämään palvelua, mutta valmentaa heitä ennen viestin lähettämistä. Valmennusviestissä, joka on käyttäjälle tuleva ponnahdusikkunassa, voi olla varoitus tekstin asiayhteydestä tai muita yrityksen riskienhallinnan antamia riskiin liittyviä ohjeita. Tällä vaihtoehdolla yrityksen työntekijät saavat selata ChatGPT:tä, mutta kun he kirjoittavat viestiä, heitä kehotetaan hyväksymään riski ja vahvistamaan, että he aikovat käsitellä tietoja asianmukaisesti.

Kaikkein kattavin tapa

ChatGPT-aktiviteetin hallinta niiden tietojen ja toimintakontekstin perusteella. Ehkä yritys haluaa, että käyttäjät voivat käyttää palvelua vapaasti, mutta he ovat silti huolissaan siitä, mitä he viestittävät siellä. Koska älykäs, pilvipohjainen ja moderni tietoturvaratkaisu, ymmärtää sovellusten sisällä olevia toimintoja, sille on mahdollista luoda tarkasti sillle toteutettu sovellus, joka tunnistaa ChatGPT-viestien post activity -toiminnon. Kun tämä on tehty, on vain luotava käytäntö arkaluonteisten tietoprofiilien estämiseksi ratkaisun DLP-moottorin avulla. Kyseinen tietoprofiili voi sisältää lähes mitä tahansa, esimerkiksi PII-tietoja tai hyvin erityisiä yrityksen IPR-tietoja tai avainsanoja. Kuten edellisessä esimerkissä, tässä tapauksessa yrityksen työntekijälle näytetään ponnahdusikkuna, jossa todetaan, että yritetty toimenpide tai tietosisältö rikkoo yrityksen tietoturvakäytäntöjä ja on siksi estetty.

Edelliset kontrolliesimerkit 2 ja 3 edellyttävät sitä, että yrityksellä on käytössä sellaista modernia tietoturvaa, joka kykenee ymmärtämään sekä datan sisällön että käyttäjän aktiviteetit. Tällainen on Netskope SASE/SSE. Yllä olevat kontrolliesimerkit ovat siinä helppoja ja nopeita toteuttaa, ja ne ovat jo käytössä sekä meillä itsellämme, että joillain meidän Netskope-asiakkaillamme.

Jos haluat kuulla lisää, niin ota rohkeasti yhteyttä, me kyllä kerromme lisää ja autamme.